Encontrar la pregunta de investigación para un proyecto científico es el punto más importante de toda metodología de estudio. Gracias a esta, vamos a confeccionar la hipótesis, desarrollar el tema y encontrar el diseño y método acorde para poder sacar nuevas conclusiones. Por eso, debemos valorar la pertinencia de nuestra pregunta. A partir de los criterios FINER esta evaluación es posible. En el presente trabajo se analizara que son dichos criterios, como y cuando se utilizan, y las estrategias para su correcta aplicación.

Seguí leyendo “La pregunta de investigación: ¿Qué son los criterios FINER?”¿Cuáles son las diferencias entre los enfoques cuantitativo y cualitativo de investigación?

Objetivo educativo:

El siguiente articulo tiene por fin que el lector comprenda los enfoques cuantitativos y cualitativos de la investigación científica, sus características y diferencias. Así mismo saber cuando utilizarlos, dando ejemplos de los mismos para una mayor compresión.

Características del enfoque cuantitativo y enfoque cualitativo

La Investigación se define como “un conjunto de procesos sistemáticos y empíricos que se aplica al estudio de un fenómeno.

La Investigación científica se realiza aplicando métodos basándose en razonamientos, representaciones y acciones como observar, experimentar, comunicar, dialogar y transformar dando lugar a la Investigación cuantitativa y la Investigación cualitativa. Ambos enfoques de investigación emplean procesos cuidadosos, metódicos y empíricos para generar conocimiento. Los dos constituyen un proceso que, a su vez, integra diversos procesos.

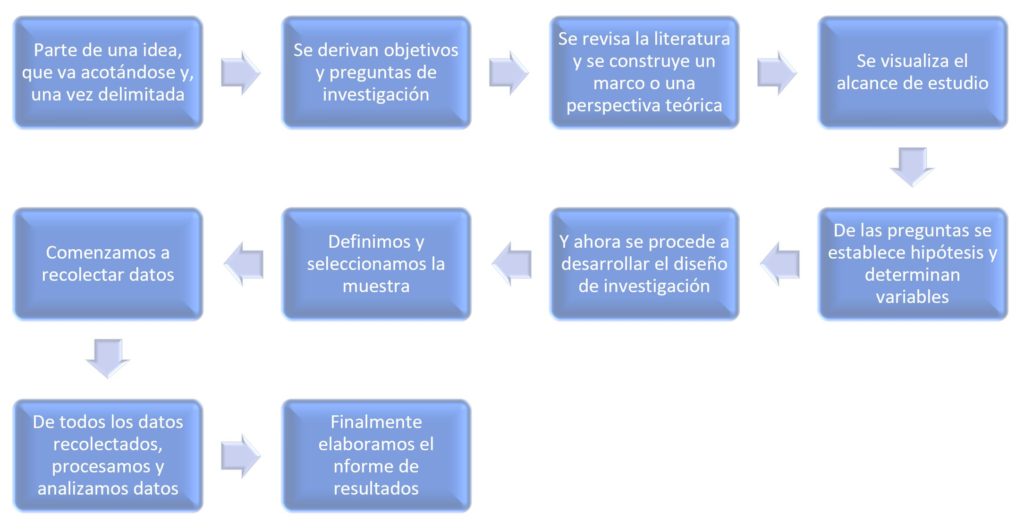

El enfoque cuantitativo es secuencial y probatorio. Cada etapa precede a la siguiente y no podemos “brincar o eludir” pasos, el orden es riguroso, aunque, desde luego, podemos redefinir alguna fase.

El proceso de investigación cuantitativa tiene pasos a seguir:

Por otro lado el proceso cualitativo es “en espiral” o circular, donde las etapas a realizar interactúan entre sí y no siguen una secuencia rigurosa. Utiliza la recolección de datos sin medición numérica para descubrir o afinar preguntas de investigación en el proceso de interpretación. En la mayoría de los estudios cualitativos no se prueban hipótesis, éstas se generan durante el proceso y van refinándose conforme se recolectan mas datos o son un resultado del estudio.

Su propósito es la de “reconstruir” la realidad tal y como la observan los actores de un sistema social previamente definido. A menudo se llama “holístico” porque se aprecia de considerar el “todo”. Sin reducirlo al estudio de sus partes.

¿Cuáles son las diferencias entre un enfoque cuantitativo y un enfoque cualitativo?

La principal diferencia de ambos enfoques es que el enfoque cuantitativo se basa en números y cálculos matemáticos , mientras que el cualitativo es más subjetivo, se basa en narrativas escritas o habladas. Está muy abierto a la imaginación y/o creatividad del investigador.

El enfoque cualitativo busca principalmente “dispersión o expansión” de los datos e información, mientras que el enfoque cuantitativo pretende intencionalmente “acotar” la información.

El estudio cuantitativo se utiliza para consolidar las creencias (formuladas de manera lógica en una teoría o un esquema teórico) y establecer con exactitud patrones de comportamiento en una población; y el cualitativo construye creencias propias sobre el fenómeno estudiado como lo sería un grupo de personas únicas.

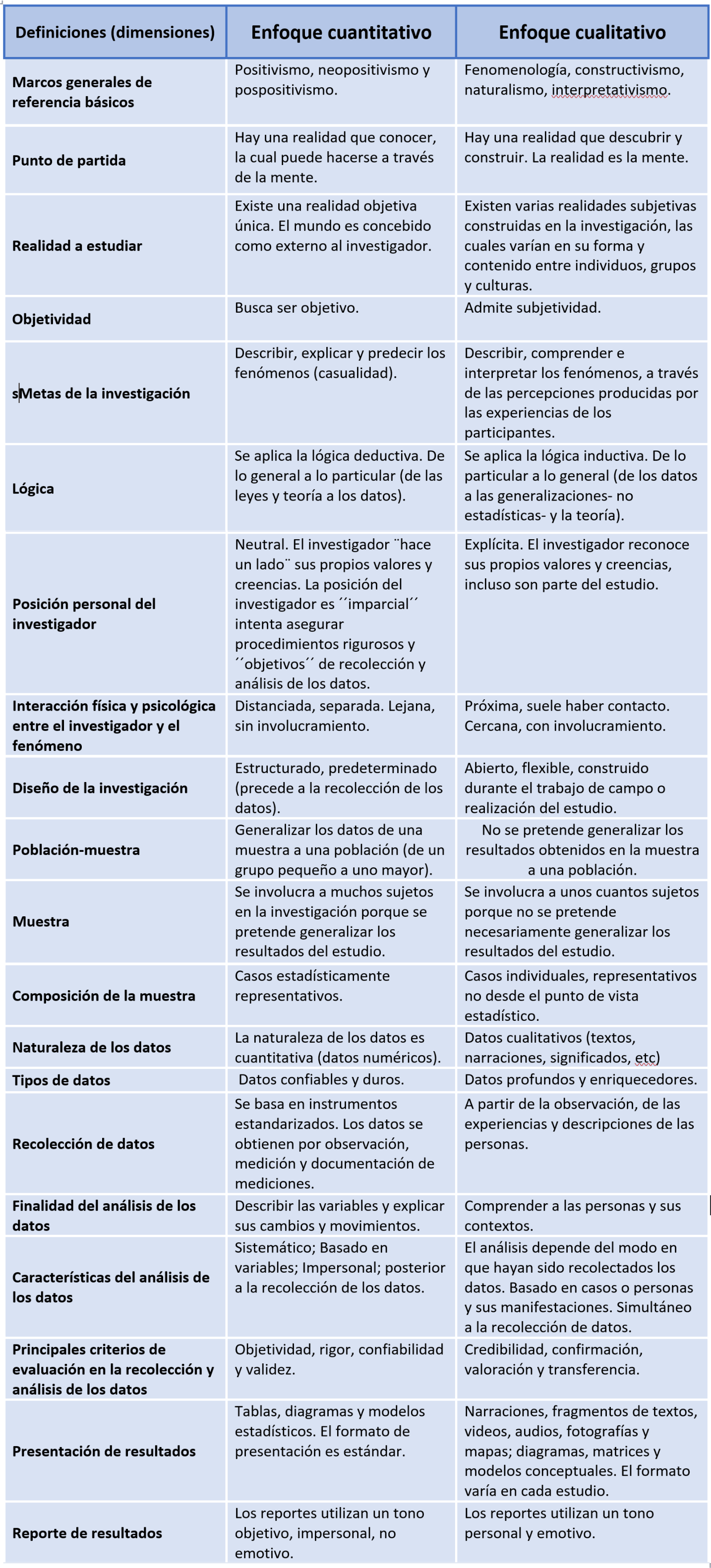

Para reforzar y ahondar en sus diferencias expongo a continuación un cuadro comparativo de cada enfoque:

¿Cuándo usar la investigación cuantitativa o cualitativa?

La investigación cuantitativa tiene la ventaja de la escala. Permite que grandes cantidades de datos, extraídos de un gran número de personas, sean recolectadas y analizadas.

La investigación cualitativa, por otro lado, se realiza con pequeños muestreos. De ella se consigue extraer datos más subjetivos, con preguntas abiertas, lo que permite conocer más sobre el individuo.

La investigación cualitativa a menudo abre nuevas opciones e ideas que no se conseguirán con una investigación cuantitativa por su naturaleza cerrada.

Ejemplos de investigaciones cuantitativas y cualitativas

Las investigaciones cualitativas se utilizan para estudiar casos individuales y descubrir cómo la gente piensa o se siente en determinados aspectos.

También se puede utilizar para explorar un tema que aún no se conoce, como en el caso de una empresa que necesita saber cómo está su imagen en el mercado.

Las encuestas cuantitativas se utilizan para estudiar las tendencias en grandes grupos de forma precisa, o medir datos de sociedades, como en el caso de un censo, o encuestas de intención de voto.

¨La investigación cuantitativa y cualitativa son hasta ahora las mejores formas diseñadas por la humanidad para investigar y generar conocimientos¨ Roberto Hernández Sampieri

Referencias:

(1). Roberto Hernandez Sampieri , Carlos Fernández Collado, Pilar Baptista Lucio. Metodología de la Investigación. Ed. Mc Grill Hall, 5ta Edición, México, 2004.

(2). Gabriela Morán Delgado, Darío Gerardo Alvarado Cervantes. Métodos de Investigación. Ed. Pearson, México, 2010.

(3). César Augusto Bernal Torres. Metodología de la Investigación. Para administración, economía, humanidades y ciencias sociales. Ed. Pearson, 2da Edición, México, 2006.

(4). SANCHEZ FLORES, Fabio Anselmo. Fundamentos epistémicos de la investigación cualitativa y cuantitativa: consensos y disensos. Rev. Digit. Invest. Docencia Univ. [online]. 2019, vol.13, n.1, pp.102-122. ISSN 2223-2516. http://dx.doi.org/10.19083/ridu.2019.644.

¿Qué es un experimento?

Resumen:

El experimento hace parte de las fases necesarias para la conclusión de un trabajo científico. Desde hace muchos anõs se conoce el experimento y ha sido utilizado en la práctica . En la actualidad, la actividad experimental se há destacado como una herramienta muy importante en la ciencia. Un experimento es un procedimento llevado a cabo para apoyar y/o validar una hipótesis. En ese trabajo analizaremos el concepto de experimento y su evolución histórica con enfase en las publicaciones científicas, a demás de analizar los tipos de experimentos y sus variables.

Desarrollo del tema:

El experimento es algo muy antiguo , en la edad media ya se conocía su importancia, sin embargo solo en el siglo XVI Galileo pasó a intentar planificarlo y organizarlo. Galileo Galilei creia que la experimentación constituía un punto central en el método científico, basado en un enfoque teórico, en el planeamento del método y en la elaboración de los experimentos. Un ejemplo muy famoso de los experimentos realizados por el italiano fui de la caída de los cuerpos . Muchos son los experimentos que se han llevado a cabo a lo largo de la historia y que han servido para avanzar en las ciencias. (1)

Otro ejemplo de experimento que se puede nombrar es el Experimento de Griffith, en el año de 1928, el microbiológo pudo demostrar que las bacterias tenían la capacidad para transferir su información genética, generando un gran avance para la ciencia y para la medicina, así se puede percebir la importancia de los experimentos para la humanidad. (2)

En el proceso enseñanza-aprendizaje , Galiazzi afirma que hace mas de un siglo las actividades experimentales fueron implantadas en escuelas, despues de seren influenciadas por los trabajos desarollados en universidades con el objetivo de mejorar el aprendizaje del contenido científico, porque los alunos sabian los contenidos, pero no sabian aplicarlos. Pero fue solo en la década de 60 que la experimentación llegó a su auge, esencialmente por influencia de los Projetos Curriculares Americanos, tais como o CHEMS (Chemical Educational Material Study) e CBA (Chemical Bond Approach Project). (3)

A través del tiempo, el experimento se ha estudiado y cambiado mucho, por eso ha generado muchas discusiones. Distintos autores lo han interpretado de diferentes maneras y por lo tanto han llegado a diversas definiciones, algunas veces contradictorias. Del latín experimentum, experimento es la acción y efecto de experimentar (realizar acciones destinadas a descubrir o comprobar ciertos fenomenos. Podemos considerar que los experimentos son preguntas que hacemos a la naturaleza para que ella revele lo que no es obvio. Tiene como objetivo obtener todas las informaciones confiable sobre el tema que queremos estudiar. En otras palabras, un experimento es algo que hacemos para descubrir algo desconocido o previamente oculto, y su resultado es aportar validez a una teoría. Toda vez que un experimento es hecho por otro avaliador y se comproba la misma teoria, la validez se incrementa. En la actualidad, con el enriquecimento de la actividad científica, la experimentación sigue adquiriendo importancia, ya que mediante ella se pueden analizar algunos mecanismos que posibiliten aislar el fenómeno estudiado y obtener el resultado buscado. (4)

El método científico es un proceso de produción del conocimento, realizado con una rígida secuencia de reglas que comiezan con la observación y finalizan con la conclusión, con el fin de obtener resultados mas confiables (CHIZZOTTI, 1991). Denominamos método al “modo ordenado de proceder para llegar a un resultado o fin determinado, especialmente para descubrir la verdad y sistematizar los conocimientos” (Diccionario Actual de la Lengua Española). (5)

El método se basa en el desarrollo de distintas etapas que conducen al establecimiento de una conclusión válida sustentada en la verificación de una hipótesis .(6)

El experimento que és donde el pesquisador realiza experiências para probar la veracidade de su hipótesis, es una de las etapas para la conclusión de un trabajo cientifico, por eso su importancia. Un estudio que se realice con las reglas basicas del método cientifico deberán tener por lo menos las siguientes etapas:

1- Observación.

2-Formulación de hipótesis

3- Experimentación

4- Conclusión.

5-Publicación y comparación.

La ultima fase del método científico consistirá en publicar y compartir las conclusiones obtenidas . Para ampliar el conocimiento en general y para que otros científicos puedan revisar y estudiar dichas conclusiones.

Tipos de experimentos

Los experimentos pueden ser clasificados en:

Experimentos naturales: también pueden ser llamados de cuasi-experimento. Implica en hacer una predicción o formar una hipótesis y posteriormente recopilar datos observando un sistema. No es posible controlar las variables en un experimento natural.

Experimentos controlados: Es realizado sob condiciones controladas, quiere decir que apenas un o pocos factores pueden ser alterados, pero la mayoria de los factores deben mantenerse constantes. Se hace comparando un grupo experimental con un grupo de control. Idealmente, estos dos grupos son idénticos excepto por una variable. Normalmente experimentos realizados en laboratorios son experimentos controlados, pero no quiere decir que no es posible realizar experimentos controlados fuera del entorno de laboratorio. Un ejemplo simples y claro es cuando decido plantar dois vasos iguales con frijoles. En ambos vasos pongo 10 semientes de frijoles plantadas al mismo tiempo, con la misma tierra y en el mismo lugar, cerca de la ventana. La unica diferencia es que solo uno de los vasos recibe agua todas las mañanas y el otro nunca recibe agua. Una semana después , 9 de las 10 semientes en el vaso que recebió agua germina y el vaso que nunca recebio agua, ninguna semiente germino. Por eso a traves de ese experimento podemos concluir que la hipótesis de que las “semientes necesitam de água” es correta.

Experimentos de campo: un experimento de campo puede ser un experimento natural o controlado y se realiza en el entorno del mundo real, no necesita ser en ambiente de laboratorio. Un ejemplo de experimento de campo seria con un animal en su hábitat natural. .(6)

Variables en un experimento:

Una variable es cualquier medida que tenga la capacidad de cambiar o controlar un experimento. Ejemplos de variables son duración del experimento, temperatura, material ultilizado, cantidad de luz, etc. Hay tres tipos de variables en un experimento: variables controladas, variables dependientes y variables independientes.

Las variables controladas, son variables que se mantienen sin cambios, por eso son constantes. Por ejemplo, utilizando todavia el ejemplo de los frijoles mencionado anteriormente, el água que recibe uno de los vasos con las semientes es un ejemplo de variable independiente porque ella no depende de lo que ocurre en el experimento. Ao revés, ella es algo que el próprio investigador elige, aplicar el água o no. (7)

La variable dependiente es la respuesta que es medida para ver se el tratamiento realmente posee alguno efecto. Continuando con el ejemplo de los frijoles, la fracción de las semientes de los frijoles que germinó es una variable dependiente. La variáble dependiente es la fracción de las semientes que germinó depiende de la varible independente que es la cuantidad de água, y no al revés.(8)

La variable independiente es la que se pone a prueba a nivel experimental, puede ser manipulada por los cientificos con el objetivo de probar una hipótesis. Es el único factor que está cambiando, un experimento intenta cambiar una cosa a la vez. Un ejemplo de variable independiente es la cuantidad de agua utilizada en el experimento. (9)

Referencias:

(1) Cruz, I. (2002). El hombre de la torre inclinada. Alfaomega Colombiana SA. Disponible en: <https://es.scribd.com/document/245894287/El-Hombre-de-La-Torre-Inclinada>. Acceso 27/04/2020 a las 9:00.

(2) Caroline Belotto Batisteti* Elaine Sandra Nicolini Nabuco de Araujo** João José Caluzi***OS EXPERIMENTOS DE GRIFFITH NO ENSINO DE BIOLOGIA: A TRANSPOSIÇÃO DIDÁTICA DO CONCEITO DE TRANSFORMAÇÃO NOS LIVROS DIDÁTICOS. Rev. Ensaio | Belo Horizonte | v.12 | n.01 | p.83-100 | jan-abr | 2010. https://www.scielo.br/pdf/epec/v12n1/1983-2117-epec-12-01-00083.pdf. Acceso : 27/04/2020 a las 10:30.

(3 )SILVA, Raquel Thomaz da; CURSINO, Ana Cristina Trindade; AIRES, Joanez Aparecida and GUIMARAES, Orliney Maciel. CONTEXTUALIZATION AND EXPERIMENTATION AN ANALYSES OF PAPERS PUBLISHED ON THE SECTION “EXPERIMENTATION ON CHEMISTRY EDUCATION” FROM THE JOURNAL “QUIMICA NOVA NA ESCOLA” 2000-2008. Ens. Pesqui. Educ. Ciênc. (Belo Horizonte) [online]. 2009, vol.11, n.2, pp.277-298. ISSN 1415-2150. https://doi.org/10.1590/1983-21172009110206. Acceso : 27/04/2020 a las 11:20

(4)Autores: Julián Pérez Porto y María Merino. Publicado: 2010. Actualizado: 2013.Definición de experimento. Disponible en < https://definicion.de/experimento/ >. Acceso 27/04/2020 a las 12:30.

(5) Autor: Yolanda Castán INTRODUCCIÓN AL MÉTODO CIENTÍFICO Y SUS ETAPAS. Disponible en:<http://www.ics-aragon.com/cursos/salud-publica/2014/pdf/M2T00.pdf >. Acceso 28/04/2020 a las 13:20.

(6) Kethelen Amanda Silva (FDCON)1 Carlos Alexandre Rodrigues de Oliveira (UFMG/FDCON)2. MÉTODO CIENTÍFICO: O CONHECIMENTO COMO UMA UNIDADE EM QUE TODOS OS SABERES ESTÃO CONECTADOS. Disponible en:< http://uniesp.edu.br/sites/_biblioteca/revistas/20170509163958.pdf >. Acceso 28/04/2020 a las 16:00.

(7) Experimentos controlados Khan academy. Disponible en: < https://pt.khanacademy.org/science/biology/intro-to-biology/science-of-biology/a/experiments-and-observations/> .Acceso en 29/04/2020 a las 14:30.

(8) Anne Marie Helmenstine, Ph.D. September 20, 2018, What Is an Experiment? Definition and Design. Disponible en: <https://www.thoughtco.com/what-is-an-experiment-607970> Acceso 30/04/2020 a las 17:45.

(9) Oscar Castillero Mimenza, Variable dependiente e independiente: qué son, con ejemplos. Disponible en: <https://psicologiaymente.com/miscelanea/variable-dependiente-independiente>. Acceso en 30/04/2020 a las 20:46.

¿Qué es el test de contraste de hipótesis? Todo lo que debo saber.

Existe un refrán galés originado en 1860 que dice: “Eat an apple on going to bed, and you’ll keep the doctor from earning his bread”. Esta frase ha sufrido modificaciones a lo largo del tiempo y es así como hoy en día se ha transformado en “An apple a day keeps the doctor away“. Si deseáramos adaptar todavía más esta frase al ámbito médico, podríamos simplemente cambiar la palabra «apple» por «aspirina»

De esta manera queda conformada una hipótesis; «Una aspirina al día mantiene al doctor en la lejanía». Pero… ¿Cómo podemos saber si esto realmente es así?, ¿Cómo sabemos si la hipótesis planteada es verdadera?, ¿De qué depende que una hipótesis se torne falsa?

La hipótesis y su problemática

Una hipótesis es algo que se supone como cierto o verdadero. Desde el punto de vista del Método Científico es una solución provisoria que aun no ha sido comprobada y que puede presentar distintos grados de fiabilidad. Una vez que esta queda verificada, pasa a ser un enunciado.

Las investigaciones que se realizan en el terreno de la medicina suelen ser del tipo comparativas. Es decir, se toman muestras poblacionales aleatorias y se analiza el efecto que producen los tratamientos en ellas. Su finalidad es observar qué tan efectivo es determinado fármaco o cómo responden los individuos a determinada terapia.

El problema que se nos plantea es si los resultados que obtenemos durante la investigación están dados por los efectos propios del fármaco o por alguna característica especial que pudieran llegar a tener los individuos de nuestra muestra tomada al azar.

Aquí es cuando entran en escena los Test de Contraste de Hipótesis y los errores asociados a ellos.

Test de Contraste de Hipótesis

También denominado prueba de significación; es un procedimiento basado en la evidencia de una muestra y en la teoría de probabilidades, usado para determinar si la hipótesis es una afirmación razonable.

En este test debemos enfrentar dos hipótesis opuestas formuladas al inicio del estudio. Una de ellas, la “suposición a favor”, es la hipótesis nula (H0). La hipótesis alternativa (H1) será la que se acepte cuando la hipótesis nula sea rechazada.

Si aplicamos esto a nuestro ejemplo, podemos establecer que:

- H0: «Una aspirina al día mantiene al doctor en la lejanía»

- H1: «Una aspirina al día NO mantiene al doctor en la lejanía» (o alguna hipótesis similar)

Durante la investigación siempre se empieza suponiendo que la H0 es verdadera. Se utilizarán los datos de la muestra para decidir si la evidencia está mas a favor de H0 o de H1. A partir de esto se obtiene una conclusión:

- Se acepta H0 y queda como verdadera

- Se rechaza H0 y queda como verdadera H1

La hipótesis nula se rechaza solo si los datos ofrecen suficiente evidencia para no considerarla verdadera

Pero aquí, volvemos a una de nuestras incógnitas iniciales.

El problema que se nos plantea es si los resultados que obtenemos durante la investigación están dados por los efectos propios del fármaco o por alguna característica especial que pudieran llegar a tener los individuos de nuestra muestra tomada al azar.

Se han realizado innumerables estudios sobre el efecto de la aspirina en los adultos mayores. Algunos llegan a la conclusión que la aspirina tiene un efecto favorable mientras que otros no solo no han visto ninguna mejoría en la salud, sino que ademas, aumenta el riesgo de hemorragias considerables (3).

Supongamos que se dispone de una población de 1.000 individuos y que para el estudio usaremos 5 muestras de 200 personas seleccionadas al azar. Los resultados no serán los mismos en todas las muestras al finalizar el estudio. Las diferencias se le van a atribuir al azar y no específicamente al fármaco que estemos probando, en este caso, la aspirina.

Entonces, ¿Cómo determinamos cuanta es suficiente evidencia?

Aquí entra en juego lo que se conoce como Nivel de Significancia, que es la probabilidad de rechazar la H0 cuando realmente es verdadera. En otras palabras, nos da un criterio para determinar si se tiene suficiente evidencia para descartar nuestra hipótesis nula. Un nivel de significancia aceptable varía entre 1 y 5%, ya que lo que menos queremos es que nuestra hipótesis nula sea rechazada cuando las probabilidades de ser verdadera son altas.

Al estar estudiando muestras y no una población entera, podemos cometer errores asociados a la aceptación o rechazo de la hipótesis nula. Se los conoce como errores alfa y beta.

- Error alfa o tipo 1: se comete cuando se rechaza una hipótesis que es correcta

- Error beta o tipo 2: se comete cuando se acepta una hipótesis que es incorrecta

Entonces; en el error alfa podemos decir que por causa del azar (patologías o condiciones de cada paciente) la aspirina no tiene ningún beneficio; y por otro lado, en el error beta y también por causa del azar (pacientes sin patologías) se acepta que la aspirina si es beneficiosa. En este ultimo caso, terminaríamos exponiendo a los pacientes a posibles hemorragias de gran calibre.

En definitiva, las pruebas de contraste de hipótesis intentan aceptar o rechazar una hipótesis nula, calculando la probabilidad de que los resultados obtenidos sean producto del azar. Gracias a ellas podemos calcular que tan probable es que en una investigación los resultados estén condicionados y determinados por el azar y que las diferencias que observamos sean debido a eso.

Referencias:

- Pruebas de contraste de hipótesis. Estimación puntual y por intervalos. Ágata Carreño Serra. SEDEN, Sociedad Española de Enfermería Nefrológica.

- Introducción a la probabilidad y estadística. Mendenhall, Beaver, Beaver. Cengage Learning. 2010. ISBN-13: 978-607-481-466-8

- Effect of Aspirin on Disability-free Survival in the Healthy Elderly. John J. McNeil, M.B., B.S., Ph.D., Robyn L. Woods, Ph.D., Mark R. Nelson, M.B., B.S., Ph.D. The New England Journal of Medicine DOI:10.1056/NEJMoa1800722

- Why an aspirin a day no longer keeps the doctor away …Marie Lordkipanidzé. University of Birmingham, Edgbaston, Birmingham, UK. doi: 10.1160/TH10-11-0749

Tipos de Estudios Epidemiológicos: Experimentales, Observacionales, Descriptivos y Analíticos

Objetivo educativo:

El objetvo por parte de este artículo es ofrecer una noción general de los conceptos básicos acerca de los estudios epidemiológico de tipo experimentales y no experimenales. También explicar la metodología de como aproximarse a un diseño de estudio adecuado y como analizar los principales criterios que se necesita tener en cuenta a la hora de elegir uno.

Desarrollo del tema:

La epidemiologia se define como la Ciencia del razonamiento y del método, usado tanto en la medicina cuanto en otras ciencias. Se aplica a la descripción de la distribución de las enfermedades y de los fenómenos de salud, la explicación de su etiología y evaluación de la repercusión de estos eventos en el ámbito de la población, la búsqueda de tratamientos y métodos de intervenciones eficaces. Dentre los estudios epidemiológicos, el diseño elegido es el arreglo de las unidades utilizadas para controlar el error experimental. El término diseño se refiere al plan o estrategia concebida para obtener la información que desea (5)

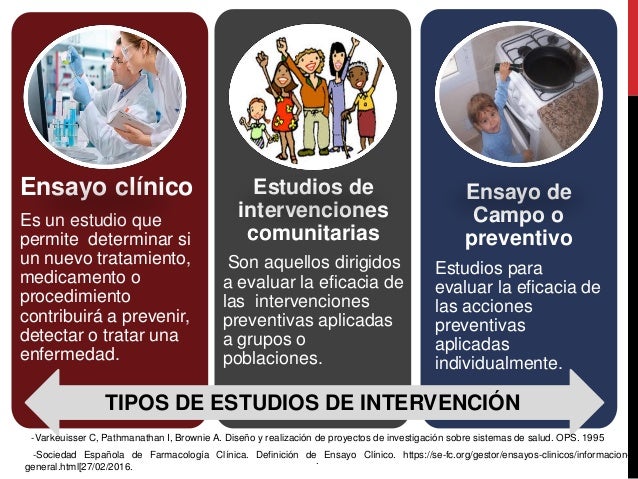

Los estudios epidemiológicos se clasifican básicamente en dos tipos:

- Experimentales: cuando el investigador controla la exposición y utiliza la aleatorización como método de asignización.

- No Experimentales: (también llamado de observacionales) cuando la exposición ocurre sin la participación del investigador y con la presencia de variables que están fuera de control del investigador, a través de la detección y descripción de los problemas de salud que aparecen en una comunidad.

Dependiendo del tipo de problema que tenemos, del tiempo que dispongamos y de presupuesto disponible, elegimos el tipo de estudio epidemiológico más adecuado para contestar a nuestras preguntas. Antes de empezar un estudio, también debemos tener en cuenta el cuales son los objetivos del estudio en cuestión, la población en que se va a estudiar, y las variables en que se van a recoger, entre otros aspectos básicos.

Estudios Experimentales

Se define estudios de tipo experimentales cuando el investigador define cada una de las características de los grupos, asignando a un determinado grupo un fármaco, tóxico, prueba diagnóstica, factor de riesgo u otro aspecto a ser estudiado.O sea, están definidas las variables y los mecanismos de control de dichas variables. El término experimento se refiere a elegir o realizar una acción y después observar las consecuencias, el inestigador genera una situación para tratar de explicar cómo afecta a quienes participan. (5)

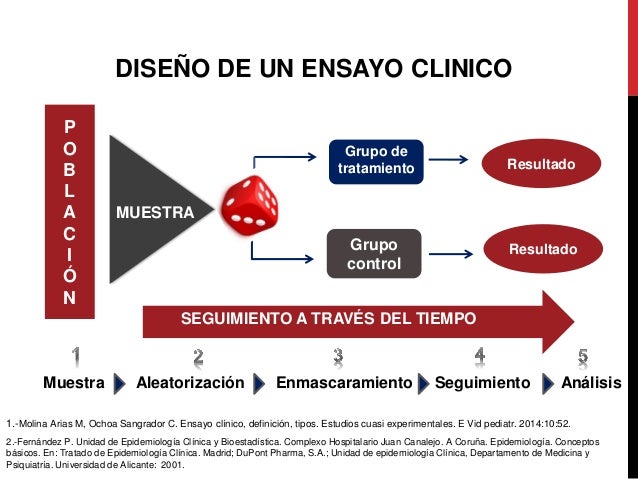

En los estudios de tipo experimentales se encuentran los ensayos clínicos aleatorizados y controlados, en donde se utiliza de la aleatorización como método de asignización a grupos clasificados como “grupo de estudio” y “grupo control”, para recibir o no determinado procedimiento, maniobra, intervención o tratamiento. Proporcionan el máximo grado de evidencia para confirmar la relación causa efecto entre la exposicióny el evento a ser estudiado.

Su principal función es evitar los sesgos (error muestral) y las variables de confusión, mediante tres procedimentos: a) de intervenciones o de exposiciones. b) de los grupos en estudios, y c) de los procedimientos para recopilar la información obtenida de la población. (1).

Características fundamentales:

- Hay una intervención por parte del investigador

- Uso de un control como comparación

- Se utilizan los resultados en una muestra limitada de pacientes

Ventajas:

- Mayor control en el diseño

- Menos posibilidad de sesgos

Desventajas:

- Costo elevado

- Limitaciones de tipo ética

- Responsabilidad en la manipulación de la exposición

- Dificultad en la generalización debido a la selección

Por ultimo, es importante mencionar que la comparabilidad de la información se logra cuando se utilizan exactamente los mismos métodos de seguimiento y de medición en todos los participantes en el estudio. Una manera de lograr esto es cegando a los evaluadores y a los participantes en el estudio ( duplo-ciego). Los evaluados desconocen la pertenencia de las personas que serán evaluada, es probable que la medición no se vea afectada por esta información. (2

–

Dentro de los estudios experimentales, también se encuentra los ensayos de campo, en donde las personas seleccionadas no han adquirido la enfermedad o esten en riesgo de adquirirlas. Estudian factores preventivos de la enfermedad, como por ejemplo la administración de vacunas o el seguimiento de dietas. (6)

Los ensayos comunitarios, incluyen intervenciones sobre bases comunitarias amplias, en los que una comunidad reciba la intervencion mientras que otra comunidad no la recibe. (6)

–

A su vez, algunos texto (3) mencionan los estudios cuasi-experimentales como un grupo intermedio entre los estudios experimentales y no experimentales. Eses estudios también pueden ser llamados de ensayos clínicos no aleatorizados.

Son diseños adaptados de los estudios experimentales en el cual el investigador no controle la distribución individual (4). En este estudio los participantes se asignan a los distintos grupos de estudio y control mediante un método no aleatorio, o sea, el investigador es quien decide y controla la asignación y se analiza el efecto de una intervención impuesta. En este estudio también se manipulan, al menos, una variable para observar su efecto en relación con una más variables dependientes (5). En este caso, la asignación no aleatória puede dar lugar a un sesgo en los resultados finales del ensayo.

Se utilizan para estudios de laboratorio clínico, cuando hay impedimentos éticos o si no hay factibilidad económica para hacer un estudio experimental propiamente dicho.

Ventajas:

- Puede hacerse con grupos pequeños

- Bajo costo

- Menos obstáculos prácticos

Estudios no Experimentales (Observacionales)

Los estudios observacionales tienen como objetivo describir un fenomeno dentro de un determinado grupo de estudo y identificar su distribución. No existe ninguna parte de intervención por parte del investigador, se limita a observar y describir los resultados.

A su vez, los estudios observacionales pueden ser de dos tipos, analíticos o descriptivo.

Los estudios descriptivos reseñan rasgos, cualidades o atributos de la población objeto de estudio (7) . El investigador se limita a describir la frecuencia y características más importantes de un determinado problema de salud, medir la presencia, distribución o característica de un fenómeno dentro de una determinada población.

Los principales tipo de estudios descriptivos son los estudios ecológicos, estudios de series de caso y los transversales (también llamados de prevalentes).

Estudios ecológicos: En este tipo de estudio se utiliza datos agregados de toda población que sirven para describir una enfermedad en relación a variables de interés que pueden ser la edad, utilización de servicios, consumo de determinado alimento (6). La asociación entre la exposición y una enfermedad es a nivel poblacional y no de manera individual. La ventaja de este tipo de estudio es que se realiza de forma rápida, con bajo costo y con informaciones que suelen ya estar disponibles en una población.

Series de casos: Describen la experiencia de un paciente o un grupo de pacientes con un mismo diagnóstico, las característica de determinada enfermedad o del paciente que es afectado por la misma. Sirven también para mantener una vigilancia epidemiológica, ya que muchas veces se describen nuevas enfermedades o efectos adversos de determinado tratamiento.

Estudios transversales: También denominado estudio de prevalencia. La población en estudio puede ser seleccionada de manera aleatoria, y una vez bien definida la población, estudian simultáneamente la exposición y la enfermedad en un momento determinado (6). Se caracteriza por hacer una solo medición en cada individual en el tiempo en que se está realizando el estudio, la proporción de personas con la exposición está determinada por la frecuencia con que ocurren eso en la población elegida. Se utilizan para conocer la prevalencia de una enfermedad o de un factor de riesgo, valorar el estado de salud de una comunidad y determinar sus necesidades

A su vez, en los estudios analíticos el investigador relaciona de manera hipotética algún factor de riesgo o agente causal con un determinado efecto, o sea, establecer una relación causal entre dos fenómenos. El investigador no establece ningún tipo de intervención, permitiendo de esta manera hacer el seguimiento de un proceso evolutivo natural.

Los estudios analíticos se dividen en dos: estudios de cohortes y estudios de casos y controles.

Estudios de Cohorte (o de seguimiento): Son estudios también llamados prospectivos, ya que se van hacia delante, desde la exposición hasta un efecto. En este tipo de estudio se establece dos grupos cohortes, uno que será compuesto por la población expuesta al factor de riesgo, y otro que se comporta como grupo control. Establecido los grupos, se realiza un seguimiento en el tiempo para observar la frecuencia de aparición de determinado factor que esta en estudio.

Estudios de casos y control: En este estudio se elige un grupo de individuos que tienen una determinada enfermedad, y otro grupo en el que la enfermedad esté ausente. La función del grupo control es estimar la exposición en una población en que no posee la enfermedad, eso quiere decir, medir si la frecuencia del factor de riesgo entre los enfermos es superior a la que se encuentra en el grupo control.

Se caracteriza por ser un estudio retrospectivo, o sea, que mira hacia atrás y tiene como objetivo estudiar la relación, contacto o exposición previa de cada uno de los grupos. Suelen ser más rápidos y económicos.

En resumen, los estudios de Cohortes se parte desde la exposición al factor de riesgo para llegar a la enfermedad y en los estudios de Caso y Control se parte de la enfermedad para intentar establecer una relación causal previa con el factor de riesgo (6).

Referencias:

Aquí debe enumerar la bibliografía utilizada.

- Miettinnen OS. Theoretical epidemiology. Principles of occurence research medicina. Nueva York: A Wiley Medical Publication, 1985.

- Kelsey JL, Thompson WD, Evans AS. Methods in observation epidemiology. Nueva York: Oxford University Press,

- Rothman Kj, Greenland S. Modern epideemiology. 2ª. Edition. East Washington Square. PA: Lippincott-Raven Publishers, 1998.

- D. Campbell y J.Stanley – Diseños experimentales u cuasi experimentales en la investigación social

- Sampieri – Libro de Referencia Metodología de la investigación. 5ª edición.

- Pita Fernandez S. – Tipos de estudios clínicos epidemiológicos

- César Augusto Bernal – Metodología de la Investigación. 2ª Edición

- Kuehl – Diseño de Experimentos. 2ª edición

- Diseño de estudios epidemiológicos – Mauricio Hernández Avila, Francisco Garrido Latorre, Sergio López Moreno

- Modelos de estudios en investigación aplicada: conceptos y criterios para el diseño – Jorge V. de Cabo, Elena de la Fuente Días, Martha Zimmermann V.

¿Qué dice la “ley de protección de datos personales” en la Argentina? ¿Por qué es tan importante para la Investigación?

Tu trabajo esta muy bien, solo te recomendamos revisar la bibliografia y citarla con números en el texto. El video deberia explicarse en el texto de que se trata y llamarlo en ese texto como (Ver video). Por último te sugiero que agragues un item mas de sugerencias para hacer una base de datos que respete lo que dice esta ley. Saludos

Objetivo educativo:

En toda investigación se recolectan, almacenan y archivan múltiples datos cuya información, posiblemente, pertenezca a un individuo o grupo de individuos, elegidos por alguna característica en particular. Por ende, me parece imperiosa la necesidad de esclarecer tanto los conceptos de privacidad y confidencialidad como también, el marco teórico, ético y legal de la protección de datos que giran en torno a un estudio experimental.

Desarrollo del tema:

Privacidad versus Confidencialidad

Si bien estos conceptos están íntimamente relacionados no significan lo mismo.

La privacidad es el derecho que tiene cualquier persona de mantener su vida íntima y asuntos personales libre de perturbaciones. La confidencialidad, por otro lado, es el pacto que el investigador hace con el entrevistado sobre cómo manejará, gestionará y difundirá la información privada que le sea proporcionada. Es decir, la privacidad se refiere al individuo o sujeto mientras que la confidencialidad se refiere al accionar del investigador. (1)

Aspectos Éticos y Legales en el manejo de datos

Cuando se involucran seres humanos a los estudios experimentales, los investigadores se ven obligados a la revisión de aspectos tanto éticos como legales, cuyo desarrollo tienen un importante rol a la hora de tomar decisiones y realizar ciertas consideraciones.

Nadie está exento de esta revisión. El ámbito científico está fuertemente regulado. Tal es así, que para que una investigación se pueda poner en marcha, debe previamente ser aprobada por un comité de ética. Se debe corroborar que la ley “Habeas Data” se cumpla, dando garantías de respetar a todas las personas que formaron parte y a sus derechos, de cuidar su salud y su integridad. (2) Asimismo, el autor debe asegurar la veracidad de la información que publica así como de disponer, en caso de que se le requiera, de los documentos pertinentes.

¿Qué dice la ley sobre el resguardo de información?

“La ley de protección de datos o Habeas Data tiene por objeto la protección integral de los datos personales asentados en archivos, registros, bancos de datos, u otros medios técnicos de tratamiento de datos, sean éstos públicos, o privados destinados a dar informes, para garantizar el derecho al honor y a la intimidad de las personas, así como también el acceso a la información que sobre las mismas se registre (…)” (3)

Congreso de la Nación Argentina. (30, Octubre 2000). Ley de Protección de los Datos Personales [25.326]. Recuperado de http://servicios.infoleg.gob.ar/infolegInternet/anexos/60000-64999/64790/norma.htm

Dicha ley, busca resguardar a los participantes de posibles o futuros daños que podría causar la publicación y viralización de los datos publicados. Cabe destacar, que nunca una investigación, un estudio o trabajo experimental debe vulnerar la intimidad y la dignidad de un tercero.

La mejor forma para lograrlo es la redacción de un consentimiento informado(4), en donde el participante expresa voluntariamente (verbalmente y/o por escrito) su conformidad e intención de participar en la investigación, una vez explicados todos los puntos que la abarcan (objetivo, beneficios, posibles riesgos como así también que se va a hacer con sus datos, quién tendrá acceso a ellos y cómo serán publicados).

Por otra parte, otro recurso muy utilizado es la anonimización(5) y su uso es muy frecuente más que nada en ensayos clínicos. Esta consiste en la conversión de datos en una forma en que no sea posible identificar de quién se está hablando particularmente. Básicamente, es una herramienta que se basa en diferentes técnicas, que a partir del análisis masivo de datos, identifica y oculta información personal sensible con el fin de mitigar la transgresión de la privacidad de los participantes. (Ver video)

(2014, July 10). University of Edinburgh.

una gran estrategia : el plan de gestión de datos

El plan de gestión de datos (PDG) es un documento utilizado para organizar, diseñar y planificar la colección y el manejo de datos durante y después de una investigación. Es un instrumento esencial que evidencia la responsabilidad y el compromiso de los investigadores con el resguardo y la preservación de la información personal adquirida. Tal es su importancia, que su confección se declaró obligatoria en el año 2013, a partir de la sanción de la ley 26.899 sobre Repositorios Digitales, reglamentada por la Res. 753 en Noviembre de 2016.

A continuación, procederé a determinar cuales son los pasos a seguir para la confección de dicho plan de gestión de datos en base a lo establecido por el Consejo Nacional de Investigaciones Científicas y Técnicas (CONICET): (6)

- Identificar y mapear los datos que prevé colectar y/o producir durante el proceso de investigació tipología, procedencia, volumen y formatos.

- Preparar una estrategia de almacenamiento y resguardo durante el proyecto de preservación.

- Explicar como se documentarán y procesarán los datos, identificar estándares que permitan su descripción, herramientas o plataformas de gestión.

- Definir las políticas de acceso y reuso de los datos, tratamiento de datos sensibles y personales, confidencialidad.

- Definir funciones, roles y responsabilidad de los participantes que realizarán tareas relacionadas con la gestión de datos de investigación del proyecto.

En definitiva, es responsabilidad del investigador cuidar los datos que les son entregados para llevar a cabo su búsqueda y, además, es una invitación a reflexionar sobre la manera en que diseñan sus proyectos, ya que no solo deben lograr su cometido en cuanto a lo científico sino también proteger a aquellos que participan para poder llevarlo a cabo. Son ellos quienes están a cargo de gestionar estrategias para mantener la privacidad de los datos identificables, incluida la forma de manejar, usar y difundir información personal.

Referencias:

- Gestión de datos de investigación: Protección de los datos. (n.d.). Retrieved from https://biblioguias.cepal.org/c.php?g=495473&p=4398118

- Di Conza, José A., & Quiroga, Cecilia (2013). Las responsabilidades éticas en la publicación de artículos científicos. Revista Argentina de Microbiología, 45(4),219-221. ISSN: 0325-7541. Disponible en: https://www.redalyc.org/articulo.oa?id=2130/213029412001

- PROTECCIÓN DE LOS DATOS PERSONALES. (n.d.). Retrieved from http://servicios.infoleg.gob.ar/infolegInternet/anexos/60000-64999/64790/norma.htm

- Meo, Analía Inés (2010). CONSENTIMIENTO INFORMADO, ANONIMATO Y CONFIDENCIALIDAD EN INVESTIGACIÓN SOCIAL. LA EXPERIENCIA INTERNACIONAL Y EL CASO DE LA SOCIOLOGÍA EN ARGENTINA. Aposta. Revista de Ciencias Sociales, (44),1-30. ISSN: . Disponible en: https://www.redalyc.org/articulo.oa?id=4959/495950240001

- Orientación y garantías en los procedimientos de ANONIMIZACIÓN de datos personales. Aepd.es. (2016). Retrieved from https://www.aepd.es/sites/default/files/2019-09/guia-orientaciones-procedimientos-anonimizacion.pdf.

- El CONICET inicia la implementación del Plan de Gestión de Datos PGD para sus proyectos de investigación. Conicet.gov.ar. (2017). Retrieved 29 April 2020, from https://www.conicet.gov.ar/el-conicet-inicia-la-implementacion-del-plan-de-gestion-de-datos-pgd-para-sus-proyectos-de-investigacion/.

- OPS/OMS. (2019). Protocolo de Investigación: Guía para realizar investigaciones en el lugar de trabajo en la OPS.

- OPS/OMS. (2002). Pautas éticas internacionales para la investigación biomédica en seres humanos. Ginebra.

¿Qué es el Poder Estadístico y cómo se calcula?

Objetivo

El objetivo de este artículo es reflejar conocimiento a futuros investigadores sobre la correcta recolección de datos, el uso correcto de los métodos estadísticos, conocer los modelos y métodos de cálculos y enfocar en la importancia del poder estadístico en los experimentos.

Introducción

Una de las herramientas más importantes y que no debe dejar de conocer en la realización de estudios e investigaciones es la estadística. Esta disciplina constituye un eje fundamental a la hora de recolectar y analizar datos experimentales brindando una respuesta racional a las grandes incertidumbres.

Aplicado a las ciencias de la salud, esta establece la medicina basada en la evidencia, donde demuestra la veracidad y eficacia de todas las investigaciones (ya sean antibióticos, vacunas, tratamientos, efectos adversos, etc.) pudiendo cambiar la manera en la que esta se ejerce y el empleo de sus recursos.

Al llegar a esta evidencia, puede que no sea la que el investigador quiso corroborar en una primera instancia. Muchos de los errores que cometen los investigadores están relacionados con la hipótesis formulada, el tamaño de la muestra, la población, la variabilidad, el diseño e incluso la calidad de esa misma evidencia.

Desarrollo

La Estadística se ocupa de reunir, clasificar, resumir, hallar regularidades, dar significado a las diferencias observadas, y analizar los datos aleatorios; siempre y cuando la variabilidad e incertidumbre sea una causa intrínseca de los mismos, con el fin de ayudar a la toma de decisiones y formular predicciones.

Al reunir los datos necesarios para realizar su propia investigación, se tienen que tomar en cuenta diversos puntos, siendo la más importante la correcta delimitación del campo de estudio sobre su población d interés. Por lo general los experimentos se realizan tomando dos muestras aleatorias de un grupo población. (Un grupo A y un grupo B).

Una vez definida la muestra poblacional, es fundamental entender el uso y análisis del poder estadístico. Este término hace referencia a la probabilidad de rechazar una hipótesis nula.

La probabilidad de rechazar una hipótesis nula cuando es realmente falsa se representa como β.

Poder estadístico= 1 – β

Al comenzar, el investigador tiene que realizar dos tipos de hipótesis.

Una hipótesis la cual se llama hipótesis alternativa (H1= hipótesis que afirma el resultado al que se quiere concluir en la investigación), y paralelamente genera la hipótesis nula (H0= afirmación contraria a la que quiere llegar el investigador).

Cuando la hipótesis da como resultado que es no significativa, el poder estadístico revisa si realmente esta hipótesis no tiene impacto o efecto, o el problema no es la hipótesis sino otro factor, como el tamaño muestral. Este poder evita conclusiones falsas y mejora la interpretación de los resultados.

En el experimento de esta investigación, donde ya comentamos que se van a utilizar dos grupos, la H0 más común indica que no hay diferencia entre las poblaciones A y B. En cambio, la H1 afirma que hay diferencia, pudiendo esta demostrar por ejemplo la diferencia de un mismo tratamiento, afectos adversos o positivos en dos grupos diferentes.

Cuando las hipótesis estén definidas y los datos se hayan obtenido correctamente, el investigador decidirá si hay suficiente evidencia para rechazar la hipótesis nula.

Para no cometer ninguno de estos errores, se tiene que tener un alto poder estadístico. Si se tiene poco poder estadístico no se podrán detectar pequeñas diferencias entre los grupos poblacionales, generando una gran debilidad en el diseño de la investigación.

Cálculo

El poder estadístico (1- β) se calcula con la utilización de la siguiente formula(6):

Donde:

- ∆ = Diferencia entre la media de los grupos.

- Ơ = Desviación estándar conjunta.

- nT y nC = Tamaños de las muestras de cada grupo.

Para ver ejemplificado el uso de la formula Z, dejo citado este video para que demuestre el correcto cálculo del poder estadístico(10).

Conclusión

El análisis de poder estadístico es una herramienta indispensable en la realización de investigaciones ya que detecta el impacto de la investigación, permitiendo calcular el diseño, la metodología, efectos y errores de los datos siendo el tamaño muestral su principal determinante.

Puede tener múltiples resultados ya sea que la hipótesis nula sea verdadera, sea falsa, sea falsa y rechazada, o sea verdadera y rechazada.

Podemos concluir que(9):

- A mayor muestra, más poder.

- A menor efecto, se requiere mayor tamaño muestral.

- A mayor variabilidad en la población, se requiere mayor tamaño muestral.

- A menor significancia estadística, menor poder de la prueba.

Si el poder estadístico es pobre, la investigación no llegará a conclusiones firmes, su resultado será sospechoso y muy factible a sesgos.

Referencias

1. Biostatistics for the health sciences (2008), Primera edición, de R. Clifford Blair y Richard A. Taylor, publicada originalmente en inglés por Pearson Education Inc., publicada como PRENTICE HALL INC.

2. Bioingenieria e Informatica Médica. Curso: Bioestadística básica para médicos asistenciales. Cuarto Congreso Virtual de Cardiología. Septiembre 2005

3. Bioéstadística: Métodos y Aplicaciones U.D. Bioestadística. Facultad de Medicina. Universidad de Málaga. ISBN: 847496-653-1

4. Primer of Biostatistics (Glantz)(Paperback) McGraw-Hill Medical; Edición: 6 (15 de abril de 2005) ISBN-10: 0071435093 ISBN-13: 978-0071435093

5. Andrew D. Althouse, PhD Pittsburgh, PA 5 de agosto de 2015 Lenth RV. Poder post hoc: tablas y comentarios. Disponibleen: http: //www.stat.uiowa. edu / fi les / stat / techrep /tr378.pdf . Consultado el 4 de agosto de 2015. http://dx.doi.org/10.1016/j.amjcard.2015.09.013

6. Gesto Giannattasio, Nora. (2016). Análisis de Poder Estadístico y su Aplicación a Evaluaciones Experimentales. DOI: 10.13140/RG.2.1.1545.7366.

7. Introducción a la inferencia estadística. Armando Aguilar Marquéz, Jorge Altamira Ibarra, Omar García León, Profesores del departamento de Matemáticas, Facultad de Estudios Superiores Cuautitlán, UNAM.

8. Introducción a la inferencia estadística. PEARSON EDUCACIÓN, México, 2010 ISBN: 978-607-442-737-0. PRIMERA EDICIÓN

9. https://www.youtube.com/watch?v=_BHJGWfksjw

10. https://www.youtube.com/watch?v=rbpgjMABhV8

¿Qué características tiene el enfoque cuantitativo de investigación?

OBJECTIVO EDUCATIVO:

El presente estudio tiene como finalidad discutir las características del enfoque cuantitativo de la investigación científica. En este sentido, tiene como objetivo exponer un análisis sobre el tema a través de un estudio bibliográfico profundo de la temática en cuestión. Para que, asi, sea facilitado el entendimiento del tema trabajado y sus fases procesuales.

DESAROLLO DEL TEMA:

El enfoque cuantitativo deriva de una tipología de la metodología científica denominada estudio de cohorte, en el cual se explica la realidad social de manera directa y desde afuera. En este sentido, la temática del enfoque cuantitativa de la investigación posee como característica a la metodología lógica-empírica. (1)

Además, el estudio posee carácter deductivo, o sea, es construido por intermedio de la realización de procedimientos rígidos, pesquisas empíricas y de las colectas de datos.

El enfoque cuantitativo de la investigación tiene como base el modelo positivista, de forma que, posee como objetivo central proporcionar una pesquisa metodológica de formación independiente y con postura neutra, además, esa metodología actúa de manera generalista y libre, teniendo, así un modo explicativo causa-efecto y, de naturaleza objetiva y valida.(2)

CARACTERISTICAS DEL ENFOQUE CUANTITATIVO

El estudio cuantitativo utilizase del análisis de datos y forma numérica, enfocándose en el área de la estadística. De este modo, para que sea realizada el proceso cuantitativo de la investigación científica es necesario que entre los elementos del problema observados pose una conexión del origen lineal. Así, el enfoque cuantitativo visa formular padrones de comportamientos y comprobar hipótesis.(1) En ese sentido, para un buen proceso cuantitativo hace necesario la presencia de fases, las cuales se caracterizan como:

Con eso, el investigador debe plantear una problemática de análisis, que sea de naturaleza objetiva y concreta. Después que se encuentra el problema del caso, debe ejecutar una revisión literaria de las bibliografías estudiadas anteriormente, así que, se crea un marco teórico y, a través de ese marco construye la hipótesis de la investigación y se hace pruebas de la hipótesis.

Anterior a la recolección e investigación de los datos se hace la hipótesis. La recolección se basa en la medición. Y esta medición es considerada y confirmada por la corporación científica. Los datos son cambiados títulos numéricos que evaluaran de normas estadísticas. Con eso se debe controlar el andamiento de la pesquisa para que así otros posibles pensamientos sean eliminados de modo que minimice el error. Luego, se divide los datos recolectados anteriormente de forma que siga el planificación del problema. Acordar que, ese tipo de investigación (que es la investigación cuantitativa) debe ser realizada de manera objetiva, pues, ella intenta disminuir las prioridades personales. (3)

Además, tales investigaciones utiliza un modelo previsible y bien formulado y debe tener consciencia que las ideas criticas tengan sido creadas antes de la colecta de los datos. Así, tienen como finalidad generalizar los resultados obtenidos en un único grupo. Aún posee el intuito de exponer y enunciar los fenómenos expuestos, con el objetivo de alcanzar relaciones causales y regularidades entre los componentes analizados.

Los datos criados poseen los modelos de validez y credibilidad, las respuestas adquiridas ayudaran para el nacimiento de un nuevo conocimiento. Con eso, se debe manejar del pensamiento deductivo, que empieza con la teoría y de ella vienen las expresiones lógicas llamadas hipótesis, la cual el analizador intenta probar.

En ese sentido, las investigaciones cuantitativas posee la finalidad de apuntar las leyes universales y causales. En el análisis cuantitativo el estudio es realizado de modo externo al individuo.

REFERENCIAS:

1. Paradigmas, enfoques y métodos en la investigación educativa. Investigación Educativa vol. 7 23–40 (2003).

2. Bobenrieth, Astete, M. II. El proceso de investigar. Cómo investigar con éxito en ciencias de la salud (2012).

3. Monje Álvarez, C. A. Metodología de la investigación cuantitativa y cualitativa. Guía didáctica. Univ. Surcolombiana 1–216 (2011).

¿Qué es un estudio de pruebas diagnósticas? Principales características.

Objetivo:

El objetivo de este artículo, es tener un acercamiento más sencillo hacia la bio-estadística y a su vez brindar herramientas comprensibles, con el fin de entender ¿Que es una prueba diagnóstica? ¿Cuales son los lineamientos para la interpretación de la información estadística que nos ofrecen dichas pruebas? y lo mas interesante es la aplicación para posteriores investigaciones, ya que tenemos acceso a múltiples instrumentos susceptibles de exploración diaria en la medicina.

Introducción

Para hablar de una prueba diagnóstica primero tenemos que definir el término “diagnóstico” que hace referencia a recopilar datos, analizarlos y dar una interpretación de ellos, con el fin de evaluar una situación de salud-enfermedad de nuestro objeto de estudio. Según Hipócrates no hay un pronóstico correcto si no se hace un buen diagnóstico (1).

Para determinar qué una prueba es diagnóstica, tiene que ser susceptible de ser medida y por tanto, el uso de la observación o el tacto no corresponderían en la definición estricta; es así que el uso de los cinco sentidos no puede establecerse como prueba diagnóstica por sí misma, pero sí como un parámetro para la descripción de un signo que se pueda medir (presión arterial, rango de movilidad, saturación de oxígeno, frecuencia cardiaca, etc.) (2)

Los estudios de pruebas diagnósticas pertenecen al grupo de los estudios descriptivos y por lo general se basan en diseños transversales, proporcionando resultados que reflejan la realidad en un momento dado, es decir un visión estática de un grupo en un tiempo determinado.

En el ámbito de la salud, el uso de pruebas diagnósticas ha sido de uso cotidiano en los diferentes estudios, debido a los múltiples tratamientos que se pueden brindar como: farmacológico, quirúrgico, radioterápico, hormonal, trasplante de células, etc. Con el fin de tener un respuesta que tenga tanto efectividad como validez científica y terapéutica (3).

A continuación se expondrán características principales de las pruebas diagnósticas y cómo podemos hacer uso de ellas de manera más sencilla y didáctica posible. Para lograrlo nos haremos una serie de interrogantes que iremos exponiendo a lo largo del documento.

¿Cómo se evalúa una prueba diagnóstica?

Para poder evaluar una prueba diagnóstica es necesario recurrir a la validez y reproductibilidad de la misma y a su vez la obtención de valores predictivos, en el marco de una prueba gold standar o prueba de referencia para el cuestionamiento a resolver.

¿Entonces, qué se entiende por validez en el marco de una prueba diagnóstica?

Validez: La validez de una prueba en bioestadística hace referencia a que determinado experimento con determinadas características mida lo que tenga que medir, comparándolos con una prueba de referencia patrón. (4)

La validez a su vez se puede expresar matemáticamente hallando la sensibilidad, especificidad, valor predictivo positivo y valor predictivo negativo.

¿Qué es y cómo puedo hallar la sensibilidad especificidad, valor predictivo positivo y valor predictivo negativo de una prueba diagnóstica?

Sensibilidad: Es la capacidad de una prueba para detectar a los que verdaderamente están enfermos en el caso de salud- enfermedad; o de indicar los casos positivos según lo que evalué el experimento.

Especificidad: Es la capacidad de una prueba, en donde se evalúa un sujeto sano y esté sujeto de negativo en la prueba que se esté realizando.

Para poder entender un poco más sobre la sensibilidad y la especificidad, la estadística ha diseñado una tabla de 2×2 en donde cruzan los posibles resultados.

| ENFERMOS | NO ENFERMOS | TOTAL | |

| POSITIVOS | a | b | a+b |

| NEGATIVOS | c | d | c+d |

| TOTAL | a+c | b+d | a+b+c+d |

De acuerdo a una tabla de 2 × 2 podemos expresar que:

Sensibilidad = a/a+c

correspondiente a verdaderos positivos/verdaderos positivos + falsos negativos

Especificidad = d/b + d

correspondiente a verdaderos negativos/verdaderos negativos + falsos negativos.

Siendo (a+b+c+d) el total de individuos evaluados, (a+c) el total de enfermos, (b+d) el total de no enfermos al momento de realizar la prueba.

Valor predictivo positivo (VPP): representa la probabilidad de que un sujeto este enfermo ya que el resultado de la prueba fue positivo

VPP= a/ a+b

Valor predictivo negativo (VPN) indica la probabilidad de no tener enfermedad ya que la prueba fue negativa.

VPN= d/c+d

A su vez también podemos calcular los índices de error:

Proporción de falsos positivos (PFP)

PFP= c/a+c = 1- especificidad

Proporción de falsos negativos (PFN)

PFP= b/b+d =1- sensibilidad.

Y la prevalencia de la enfermedad se calcularía (a+c/a+b+c+d), siendo muy útil ya que nos muestra información sobre la prueba que se está realizando y sobre la población en estudio (5).

Para complementar lo anteriormente expuesto mire el siguiente vídeo.

¿Para qué me sirve la reproducibilidad de una prueba diagnóstica?

Entonces la reproducibilidades la capacidad de la prueba para ser reproducida por otros evaluadores, con la finalidad de comprobar la veracidad de la misma y me sirve para saber si lo puedo replicar con la población que estoy estudiando (4).

Matemáticamente existen otras formas de expresar los resultados y para eso se opta por exponer el cociente de probabilidad tanto positivo como negativo.

¿Qué es el cociente de probabilidad?

Es aquella que compara la probabilidad de conseguir un determinado resultado en un sujeto con la enfermedad, con la de obtenerlo en un sujeto en el que se ha descartado la presencia de la misma.

El cociente de probabilidad de una prueba positiva (CPP) se calcula dividiendo la proporción de casos positivos “sensibilidad” entre la proporción de sujetos que no poseen la enfermedad, los llamados falsos positivos, “1 – especificidad”.

CCP= Sensibilidad/1-Especificidad

El cociente de probabilidad de una prueba negativa (CPN) se calcula dividiendo la proporción de casos negativos “1- sensibilidad” entre la proporción de sujetos que no poseen la enfermedad, y que la prueba dio resultado negativo “especificidad”.

CPN= 1-Sensibilidad/Especificidad

Entonces de todo lo anteriormente dicho nos lleva a preguntarnos ¿Cómo se puede verificar si la prueba que estoy haciendo posee la validez suficiente?

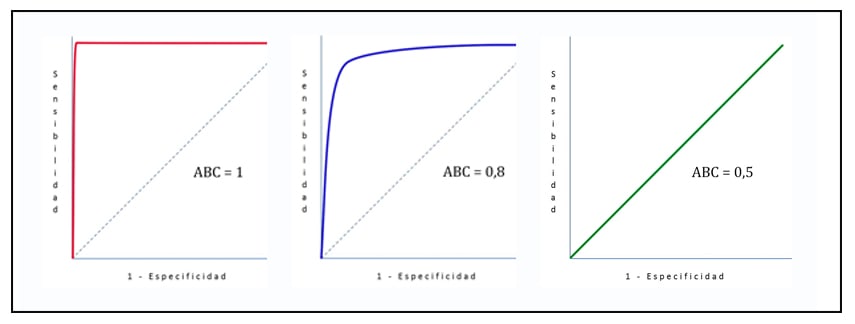

Para eso podemos explicarlo con la curva ROC (Característica operativa del receptor), la cual representa gráficamente la sensibilidad y la especificidad y su relación, derivados de los puntos de corte y sus variaciones en los rangos de los resultados mostrados en la prueba.

Los valores de área bajo la curva de ROC serán entre 0 y 1, esto garantiza la eficacia de la prueba realizada, a su vez certifica que la prueba hace una correcta diferenciación entre enfermos y no enfermos del experimento (6).

Referencias:

1. El diagnostico médico. Lorenzano, C. 2006, Subjetividad y procesos cognitivos, pág. 150.

2. Servicio de Epidemiología Santiago de Compostela. Pruebas diagnosticas. Pruebas diagnosticas. [En línea] 22 de febrero de 2006. https://www.sergas.es/Saude-publica/Documents.

3. Las pruebas diagnósticas. Su aplicación en los estudios epidemiologicos. Ávalos , O. 2000, Revista de nefrologia, Sociedad Española de Nefrología, pág. 403.

4. Unidad de Epidemiología Clínica y Bioestadística. investigación Pruebas diagnósticas. investigación Pruebas diagnósticas. [En línea] 14 de 07 de 2003. [Citado el: 21 de 04 de 2020.] www.mbe/investiga/pruebas_diagnosticas/pruebas_diagnosticas.

5. Pruebas diagnósticas: aspectos básicos de lo que el endoscopista debe saber. Duarte, A, Herrera, D y Téllez, F. 3, Ciudad de México : Elseiver, 2016, Vol. 28. 10.1016.

6. Peréz, I y Battikhi, B. Características de los test diagnósticos . Málaga : Ed Cont Lab Clín, 2017.

¿Qué es la Precisión y la Exactitud? ¿Para qué se utilizan? ¿Cómo se calculan?

Objetivo Educativo:

Este artículo tiene el objetivo de ayudar al alumno que necesite hacer un trabajo de final de carrera a entender los criterios relacionados con la exactitud y la precisión de un instrumento de medición , a fin de reducir los sesgos y promover mayor confiabilidad y validez de su estudio. En un trabajo de investigación, la integridad de los datos depende de la integridad del sistema de medición.

La precisión y la exactitud son términos que están relacionados entre si y que se refieren a la capacidad que tiene un instrumento o escala al momento de la medición de las variables. La medición tendrá mayor validez mientras más precisa y exacta sea. Si se obtiene resultados con poca variabilidad con un instrumento, se presume que este es más preciso. Ya la exactitud de un instrumento se relaciona a capacidad de obtener resultados verdaderos y libres de sesgos. (1)

La precisión en un estudio y su utilidad

Por definición la precisión es la cercanía de dos o más valores de varias mediciones entre sí. Hay más precisión mientras más cerca estén los valores de diferentes mediciones y eso tiene una grande influencia en la potencia de un estudio porque mientras más precisa sea la medida, mayor será la potencia estadística, o sea, la precisión aumenta la potencia para detectar defectos. (2)

La palabra clave aquí es reproducibilidad. Es así que se valora la precisión, con la reproducibilidad de mediciones repetidas y esto está relacionado con los llamados errores aleatorios. Algunas fuentes de errores aleatorios son: (3)

- Variabilidad del observador (incluye factores como escoger palabras en una entrevista o tener habilidad para usar un instrumento mecánico) (3)

- Variabilidad del sujeto (se debe a la variabilidad biológica intrínseca de los participantes en el estudio) (3)

- Variabilidad del instrumento (incluye factores ambientales cambiantes, el desgaste de los componentes mecánicos, entre otros) (3)

Un instrumento es confiable y preciso cuando las mediciones realizadas generen los mismos resultados en diferentes momentos, escenarios y poblaciones. Pero en la practica la confiabilidad se conjuga con otro concepto que es la validez, dando origen a diversos escenarios, desde mediciones válidas y confiables hasta aquellas que carecen de validez y de confiabilidad. (2)

Unos de los principios fundamentales de la precisión en un estudio es la confiabilidad, o consistencia de las mediciones. És necesario que los investigadores intenten reducir la cantidad de fuentes de potenciales errores relacionados con la medición de las variables para proporcionar una mayor confianza en los resultados. (2)

Existen cinco métodos que se pueden emplear para tratar de reducir al mínimo el error aleatorio y aumentar la precisión de las determinaciones de cualquier estudio: la normalización de los métodos de medida, la formación y certificación de los observadores, el perfeccionamiento de los instrumentos, la automatización de los instrumentos y por último, repetir las determinaciones. (5)

Para cada una de las mediciones del estudio, es el investigador que decide cuánto hincapié debe hacer en cada una de estas estrategias.

Como se calcula la precisión de un estudio

Se calcula a través de la proporción de verdaderos positivos contra todos los resultados positivos, tanto verdaderos positivos (VP), como falsos positivos (FP): (3)

La fórmula és:

Precision = VP/VP+FP

Ahora, cuando es necesario estimar la precisión de una población (estadísticos), esta se calcula a través de un intervalo de confianza (IC). (4)

IC es una medida de la precisión de los resultados de un estudio con la finalidad de establecer inferencias sobre la población estudiada. En ciencias de la salud se suele utilizar un intervalo de confianza de 95%, debido a que sólo es posible aceptar como máximo un 5% de error estándar en las afirmaciones. (4)

La fórmula del IC se compone de dos parámetros principales; el primero denominado (d ), diferencia entre dos medidas (proporciones, medias, medianas, entre otras) y (e ), el error estándar aceptado para esa diferencia bajo una curva normal con un valor de Z= 1.96. (4)

Por lo tanto, la fórmula en general és [d +/- 1.96(e)].

Para lo cual, el error estándar se obtiene mediante 2√p (1-p)/n, donde “p” representa a la proporción de sujetos con el evento estudiado y (1-p) a la diferencia de la unidad menos el valor de “p” que se divide entre el número de pacientes. (4)

Siempre que se trate de estudios donde se analicen diferencias entre dos o más grupos para medias, proporciones (%), riesgos relativos y también para calcular estimaciones de estudios de diagnóstico (sensibilidad, especificidad, valores predictivos positivos e índices de probabilidad), tratamiento, casos y controles, inclusive meta análisis, es necesario incluir el IC. (4)

Exactitud y su utilidad

Exactitud en una prueba diagnóstica se refiere al grado en que sus resultados coinciden con un parámetro de referencia claro y objetivo, o sea, la exactitud de una variable es el grado en que representa el valor verdadero y su utilidad para un estudio es aumentar la validez de las conclusiones. (4)

En las ciencias de la salud, se dice que la exactitud és la capacidad de una prueba diagnóstica para clasificar correctamente a los individuos en subgrupos clínicamente relevantes (enfermos y NO enfermos)”. (5)

La exactitud va a depender del error sistemático (sesgo); cuanto mayor sea el error, menos exacta será la variable. Los posibles sesgos son: (4)

Sesgo del observador: una deformación, consciente o inconsciente de la percepción o la notificación de la medida por el observador. (4)

Sesgo del instrumento: funcionamiento defectuoso de un instrumento mecánico. (4)

Sesgo del participante: la deformación de la medición por parte del participante en el estudio, por ejemplo, al notificar un suceso (sesgo de respuesta o de recuerdo). (4)

Como se calcula la exactitud en un estudio

A diferencia de la precisión, la exactitud de una medición se evalúa mejor comparándola (si posible) con algún criterio de referencia. (4)

De manera práctica, se calcula con la proporción de resultados verdaderos (positivos y negativos) entre el número total de casos examinados (verdaderos positivos, falsos positivos, verdaderos negativos, falsos negativos). Por lo tanto, la formula es: (5)

Exactitud= VP+VN/VP+FP+FN+VN

Para incrementar la exactitud de un estudio también es posible contar con estrategias parecidas a las utilizadas para determinar la precisión: normalización de los métodos de medición, formación y certificación de los observadores, perfeccionamiento de los instrumentos, automatización de los instrumentos, realización de medidas que no se perciban (es posible diseñar mediciones de las que no sea consciente el participante y así eliminar la posibilidad de que conscientemente introduzca sesgo en la variable), calibración del instrumento y enmascaramiento. (5)

La decisión del interés que se debe poner en aplicar cada una de estas estrategias, así como en el caso de la precisión, es del elección del investigador.

Referencias:

- Villasís-Keever MÁ, Márquez-González H, Zurita-Cruz JN, Miranda-Novales G, Escamilla-Núñez A. El protocolo de investigación VII. Validez y confi abilidad de las mediciones. Rev Alerg Mex. 2018;65(4):414-421

- Manterola, Carlos, Grande, Luis, Otzen, Tamara, García, Nayely, Salazar, Paulina, & Quiroz, Guissela. (2018). Confiabilidad, precisión o reproducibilidad de las mediciones. Métodos de valoración, utilidad y aplicaciones en la práctica clínica. Revista chilena de infectología, 35(6), 680-688. https://dx.doi.org/10.4067/S0716-10182018000600680

- Portillo, Jacobo Diaz. Guía Práctica del Curso de Bioestadística Aplicada las Ciencias de la Salud. Alcalá, Madrid: Instituto Nacional de Gestión Sanitaria.

- Arceo Díaz, José LuisManual de medicina basada en evidencias / José LuisArceo Diaz, José Manuel Ornelas Aguirre, Susana Dominguez Salcido. México : Editorial El Manual Moderno, 2010. xii, 192 p. : il. ; 23 cm. Incluye índice ISBN 978-607-448-054-2

- Hulley SB, Cummings SR. Planificación de las mediciones: precisión y exactitud. En: Diseño de la investigación clínica. Barcelona: Doyma, 1993; 35-46.